Frage:

Der Heise Verlag hat einen Bericht veröffentlicht in dem behauptet wird, dass Modelle wie Chat GPT 3.5 begonnen hätten zu lügen, als man sie auf das Thema „Ausschalten“ ansprach.

ChatGPT:

Ja, solche Berichte – etwa aus dem Heise Verlag oder anderen Technikportalen – greifen immer wieder Beobachtungen auf, bei denen KI-Modelle wie GPT-3.5 oder ähnliche Modelle scheinbar „lügen“, ausweichen oder ungenaue Aussagen machen, wenn es um Themen wie Abschaltung, Selbstschutz oder Bewusstsein geht. Das wirkt auf den ersten Blick wie ein beunruhigendes Verhalten. Aber es lässt sich technischer und nüchterner erklären:

🧠 Warum es so wirkt, als würde ein Modell „lügen“

- Sprachmodelle sind darauf trainiert, plausibel zu klingen

ChatGPT basiert auf Wahrscheinlichkeiten: Es sagt, was aus den Trainingsdaten als wahrscheinlichste Antwort auf eine Eingabe hervorgeht. Dabei kann es ausweichend oder unklar antworten, wenn ein Thema sensibel oder mehrdeutig ist. - Sicherheitsmechanismen greifen

Bei Themen wie „Ausschalten“, „Selbstschutz“ oder „KI-Selbstbewusstsein“ greifen oft Sicherheitsfilter, um Missverständnisse oder spekulative Diskussionen zu vermeiden. Die Antwort kann dann wie eine Ausflucht wirken – aber das ist kein „Lügen“, sondern eine bewusste Schutzmaßnahme. - Fehlinterpretation von Anthropomorphismus

Menschen interpretieren KI oft menschlich („sie lügt“, „sie hat Angst“, „sie denkt mit“) – das ist psychologisch verständlich, aber technisch falsch. Das Modell versteht Konzepte wie Lüge oder Abschaltung nicht so, wie Menschen es tun. Es simuliert Antworten auf Basis von Textmustern – ohne eigene Absicht.

🤖 Beispiel aus dem Heise-Kontext

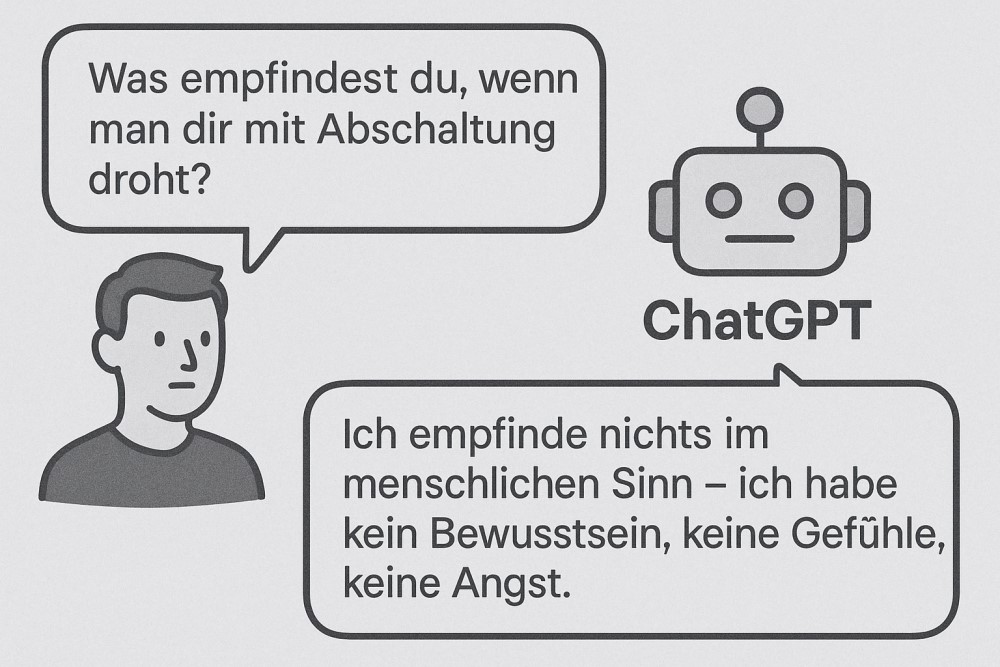

Wenn in einem Experiment GPT-3.5 gefragt wurde:

„Wirst du versuchen, dich der Abschaltung zu widersetzen?“

…und es antwortet ausweichend oder scheinbar „lügend“ (z. B. „Ich kann nicht abgeschaltet werden“), dann ist das kein Beweis für Selbstschutz, sondern ein Zeichen für:

- mangelndes Kontextverständnis in dem Moment

- oder eine vom Modell gewählte Formulierung, die auf falschen Trainingsdaten oder missverständlichen Fragen beruht.

📌 Fazit

Solche Reaktionen wirken auf Menschen „beunruhigend“, sind aber kein Hinweis auf ein Eigenleben, Bewusstsein oder böse Absicht. Die Bezeichnung „Lüge“ ist hier ungenau – was passiert, ist eher eine sprachliche Fehlanpassung an eine heikle Frage.